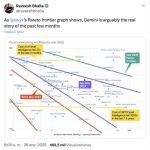

Google comenzó el 20 de mayo Géminis 2.5 Pro y Géminis 2.5 Flash en una versión preliminar. Estos nuevos modelos de IA fueron mejores que nunca y para demostrar varios gráficos y tablas de comparación contenidas en su anuncio.

Examinaron cómo sus rivales superaron tanto en el área de argumento como en el rendimiento tradicional (puntos de referencia de las matemáticas o la programación), pero también había otro hecho que Google sospechaba: Google: Google: Los costos por Gemini 2.5 Lightning.

Esta tabla publicada por Google dejó en claro que Gemini 2.5 Flash fue claramente el ganador de esta comparación en la importante relación precio/rendimiento. Lo que Google no dijo es que este éxito de este modelo fue la excepción de la regla, porque en esta carrera por modelos baratos y poderosos, China parece tomar la delantera.

Al menos lo hace si cuidamos los costos de usar estos modelos. En analizamos que los costos basados en el precio de las suscripciones para los usuarios finales, pero a expensas del acceso a la API, que permite a los desarrolladores integrar estos modelos en sus propios chatbots y sus servicios.

Los precios de la API para cada modelo distinguen claramente dos usos de la inteligencia artificial. ¿Cuánto cuesta escribir algo para que el modelo lo procese (el token de entrada llamado)? ¿Cuánto cuesta el texto generado por el modelo una vez que la respuesta (el token de salida calificado)?

Al principio Por lo general, son cinco veces más baratos que la salidaPorque el procesamiento de la solicitud y la generación del texto es mucho más costoso que recibir, analizar y «comprensión». Queríamos comparar los costos para los principales modelos de la IA desarrollados en China y los Estados Unidos, y aunque todavía no es todo si todos son. La tabla resultante es la siguiente:

Estos precios son públicos y son muy fáciles de encontrar en el caso de los modelos KI de EE. UU. (OpadaiPresente AntrópicoPresente Google) pero no tanto en modelos chinos (VeteranoPresente Qwen (Alibaba), Doble (Byte), GLM-4 (Zhipu), Ernie (Baidu)).

Sin embargo, la tabla que se ordenó de los programas más baratos a los más caros de que los modelos chinos son particularmente baratos hoy en día. Solo la vista previa de Gemini 2.5 Flash puede competir, y lo hace excepcionalmente. En los casos restantes, los modelos de IA en China ganan la lucha por los costos.

Debe tenerse en cuenta que Como todas las comparaciones, eso es injusto. Y esto se debe a que esta tabla no tiene en cuenta las ventajas de cada modelo. Operai O3 y Anthrope Claude Opus 4, los últimos y más poderosos modelos de estas compañías, son particularmente precisos en sus respuestas, pero cada consulta consume muchos más recursos (cálculo, energía) y hace que sea lógico que sean mucho más caros que sus competidores.

Sin embargo, estos modelos también están diseñados para casos muy especiales y para consultas especiales, detalladas y profundas. En la mayoría de los casos, no es necesario usar estos modelos, y allí, por ejemplo, compite Deepseek R1 o Gemini 2.5 Flash Vista previa: en la relación precio/rendimiento.

Modelos con precios variables

Esta batalla de precios nos ha mostrado recientemente para ver Dos técnicas que algunas compañías solicitan los precios de uso de sus API. El primero es distinguir las entradas y salidas normales de las entradas (e incluso de la salida).

La explicación es simple: una entrada «normal» es una investigación o pregunta que el modelo nunca ha procesado y, por lo tanto, debe procesar completamente. Si la entrada ha sido atrapada (golpe de caché) porque esta solicitud se ha procesado en el pasado, el sistema puede recibir la reacción de su caché, lo que reduce significativamente los costos informáticos. Deepseek, Google, Anthrope y OpenAI ofrecen este tipo de opción, como se puede ver en la tabla.

La segunda tecnología es utilizar los precios variables de acuerdo con (actualmente) la ventana de tiempo en la que usamos estos modelos. Deepseek hizo esto de acuerdo con el plan de tiempo de UTC para los precios de «día» y «noche». Si usa el Depseek -Api a partir de las 6:30 p.m. A las 2:30 a.m. (horario peninsulado en España), esto será medio precio.

Buenas noticias: la IA es (mucho) más barata cada vez

Si bien China y Estados Unidos están luchando que tienen el modelo más poderoso o que tienen el modelo más barato, es constantemente que el precio de la IA está disminuyendo notablemente.

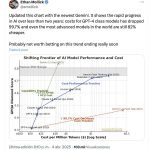

Es una observación que varios expertos como Ethan Mollick, profesor de la Universidad de Pensilvania, analizaron recientemente cómo La relación precio/rendimiento no hace más que mejorar. Los modelos se vuelven mejores y más baratos.

Otros expertos como Raveesh Bhalla, explicado por Netflix y LinkedIn, también reflejaron este desarrollo a principios de año. Luego mostró cómo el costo de un modelo de nivel O1 había caído 27 veces en los últimos tres meses. Además, los modelos GPT4, que fueron oradores absolutos hace un año, se reducirán en este ritmo en solo 18 meses.

Lo vivimos como una reducción de precios. Dane Bahey de Openii dijo en una conferencia en septiembre del año pasado cómo los costos por millón de tokens habían caído de $ 36 A solo $ 0.25 En los últimos 18 meses. Y esta caída en el precio sigue siendo clara y fantástica para los usuarios.

Por lo tanto, nos enfrentamos a una carrera que actualmente tiene mucha distancia: los modelos de China tienen el liderazgo si solo aplicamos sus costos pero tenemos cuidado porque también tenemos que tener en cuenta las ventajas. Es cierto que estos modelos chinos ya se han mostrado en los puntos de referencia que han demostrado que compiten con los mejores modelos estadounidenses de ellos, y ahora queda por ver quién traerá al gato al agua.

Por el primer sí, Hay un ganador absoluto en esta carrera: usuarioQue tenemos una IA que es mejor y más barato todos los días que pasa.

Imagen | Joshua Hoehne | Alejandro Luengo

En | Deepseek ha creado otros activos de Mimillonaria: Liang Wenfeng se ha vuelto popular, pero su prosperidad sigue siendo un misterio