Se acaba de lanzar una startup china llamada Moonshot Kimi K2 pensandoun gigantesco modelo abierto con un billón de parámetros que ha conseguido algo que parecía casi imposible: superar a los mejores modelos propietarios de compañías como OpenAI, Google o Anthropic. Si pensábamos que los modelos “open source” nunca podrían competir con GPT-5, Gemini 2.5 Pro o Claude, estábamos equivocados.

Qué pasó. Este “laboratorio de IA” ya había sido anunciado kimi k2 en julio con el tamaño gigantesco de un billón de parámetros, pero ahora han lanzado la versión “Thinking” con el mismo tamaño (32 mil millones de parámetros activos, arquitectura Mezcla de Expertos). Según sus responsables, el modelo es capaz de mantener un uso estable de las herramientas del agente durante 200 a 300 llamadas consecutivas. O lo que es lo mismo: puede encadenar largas secuencias de acción de forma autónoma y aparentemente sin errores. Sin embargo, lo mejor no es que supere al GPT-5 o al Claude Sonnet 4.5 en varias pruebas y cueste mucho menos que estos modelos.

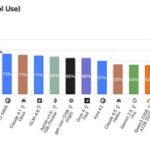

Los puntos de referencia. Los funcionarios de Moonshot explicaron cómo Kimi K2 Thinking logró las puntuaciones más altas en Humanity’s Last Exam (conocimientos generales, 44,9%) y BrowserComp (navegador de agentes, 60,2%). Está casi al nivel de Claude en la prueba de desarrollo de software de SWE y también es casi el mejor en otro de estos puntos de referencia, LiveCodeBench v6. Esto es cierto en algunas pruebas. todavía un poco atrás sus competidores «occidentales», pero el éxito es espectacular.

Más puntos de referencia. Los responsables del análisis artificial han mostrado sus primeras conclusiones después de la evaluación con diversas pruebas. Por tanto, destacan su comportamiento en tareas de agente que simulan el modelo actuando como agente de atención al cliente. En esta prueba alcanzó el 93% del máximo, superando ampliamente a todos los competidores (GPT-5 Codex High, por ejemplo, logró el 87%). Realizarán más pruebas, pero por ahora las perspectivas son fantásticas.

Y barato también. En CNBC indicar que entrenar el modelo costó 4,6 millones de dólares, una cifra ridícula teniendo en cuenta que entrenar modelos propietarios como GPT-5 costó un estimado de 500 millones de dólares. Usar la API Kimi K2 Thinking también es muy asequible: 0,6 dólares por millón de tokens recibidos y 2,5 dólares por millón de tokens emitidos. GPT-5 Chat cuesta $1,25/10 cada uno, mientras que Claude Sonnet 4.5 cuesta $3/15 cada uno.

Los detalles. El modelo utiliza la cuantificación INT4 para mejorar su eficiencia sin comprometer la precisión y calidad de sus respuestas. Su ventana contextual (el “tamaño” de los datos que podemos ingresar en las indicaciones de comando) es de 256 KB, un número relativamente modesto para modelos grandes, pero notable de todos modos. Y como es un buen modelo abierto, podemos descargarlo para usarlo localmente… cuando tengamos un auténtico monstruo a nuestra disposición. Por ejemplo, el modelo pesa 594 GB. Fusionando dos Mac Studio M3 Ultra Es posible que a nivel local funcione con relativa suavidad a unas 15 t/s.

Alibaba está detrásSí. Aunque el modelo está siendo desarrollado por una startup independiente llamada Moonshot, esta empresa cuenta con el respaldo financiero de Alibaba, que se está convirtiendo en una potencia absoluta en este espacio. Ya no se contenta con desarrollar modelos propios que destacan (Qwen es el claro ejemplo), sino que también financia el desarrollo de otros modelos como el Kimi K2/Thinking.

China y su amor por los modelos abiertos de IA. En los últimos meses hemos visto a China dominar el campo de los modelos abiertos de IA, no de “código abierto”. El gigante asiático ha adoptado una filosofía arrolladora con modelos cada vez mejores, pero hasta ahora parece estar varios pasos por detrás de los grandes modelos propietarios de OpenAI, Anthropic o Google. Este ya no es el caso.

La carrera es animada.. Este éxito representa un nuevo voto de confianza en los modelos abiertos de las empresas chinas. Aunque son enormes y, por tanto, muy difíciles de utilizar en la práctica para los usuarios finales, representan una alternativa interesante para las empresas.

Imagen | idnaklss con mitad de viaje

En | Hay muchas carreras «internas» dentro de la carrera más amplia de la IA. Y Alibaba gana el código abierto