El desarrollo de la IA ha promovido una nueva carrera en todo el mundo como «armas». No se intenta dominar otra área, sino mejor. Las empresas de tecnología más importantes utilizan centros de datos en todo el mundo con un objetivo: entrenar inteligencia artificial. Hay centros de datos que se extienden auténticamente, y en este diagrama vemos los grupos de datos más poderosos del mundo con un excelente protagonista:

Elon Muschus.

Grupo. Un tono antes de ingresar números. Cuando hablamos sobre el rendimiento del cálculo, podemos hablar sobre un clúster de computadora o una supercomputadora. Este último es un sistema extremadamente poderoso que se puede crear con procesadores que se pueden lograr especialmente para los extremos o el cálculo más común para miles de servidores de alto rendimiento. Se utilizan para simulaciones y tareas científicas que requieren un enorme procedimiento de cálculo, y sus costos son brutales.

Por otro lado, tenemos la versión «asequible» de una supercomputadora: el clúster de la computadora. Estas son una serie de estaciones de trabajo interconectadas que funcionan en paralelo en paralelo. Es similar a una supercomputadora, pero la ventaja es que es un sistema más flexible porque, dado que necesita más dispositivos, puede expandir el clúster. Además, los componentes son más estándar, lo que significa que los costos también son más bajos. Pero es un concepto que ha sido borroso en los últimos años.

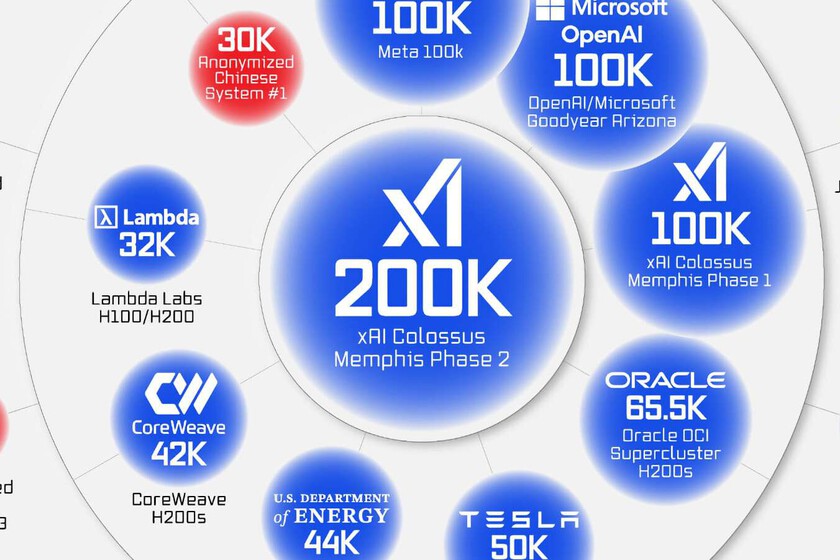

El club de 100,000. Sin embargo, volvemos al gráfico de explicado Capitalista visual Con los datos de Época AI. Actualmente podemos ver los grupos más poderosos, pero con una pequeña trampa: ambos están planeados y en funcionamiento. X, la compañía de Elon Musk, brilló el año pasado la Fase 1 de Memphis Xai Colossus, un gran centro de datos con 100,000 GPU H100 de Nvidia con el objetivo de «Grok», su modelo de IA. Fue algo que sorprendió a Jensen Huang, CEO de Nvidia.

Es un monstruo informático con un enorme rendimiento de cálculo, pero se espera que el número aumente en hasta 200,000 GPU. Más tarde veremos las consecuencias energéticas de ello. Según la compañía de Musk, tenemos meta al descubrir que tiene un clúster. «Más de 100,000 GPU H100«Llama a 4 ‘para su modelo. Luego están los que tienen algo más. Por ejemplo, por ejemplo, Microsoft con su clúster Para Azure, Copilot y OpenAI -KI estimaron que tienen 100,000 GPU entre H100 y H200.

Dos mundos. Fuera de este club de 100,000, tenemos a Oracle con su 65,536 Nvidia H200, otro musical de la Fase 1 Cortex y sus 50,000 GPU, y el Ministerio de Energía de los Estados Unidos con el Capitán, la supercomputadora más poderosa del mundo. Oficiales o estimados lo que está claro con este gráfico es que hay un país que se ha tomado en serio el cálculo de la IA: Estados Unidos.

Ellos son los que con sus centros de datos en los Estados Unidos (los 10 grupos, los primeros nueve en los Estados Unidos y China) parecen estar presionando más y no solo la construcción dentro de sus fronteras: también está fuera. Un ejemplo es el plan objetivo para crear centros de datos en España o prácticamente el tamaño de Manhattan.

Expansión europea. En el gráfico podemos ver dos grupos europeos. Por un lado, el Centro de Supercomputación Jülich en Alemania con sus GPU confirmadas. Por otro lado el Nexgen En Noruega con aproximadamente 16.300 GPU. Europa ha llevado a cabo varias iniciativas de financiación para promover su competitividad gracias a programas como Genai4eu Y su presupuesto de 700 millones de euros entre 2024 y 2026.

El objetivo es construir grandes centros de datos, y se presentaron 76 sugerencias en 16 países diferentes. Sin embargo, este desarrollo de la IA europea debe reconciliarse con la Ley AI, el acuerdo que ha entrado en vigor desde febrero de este 2025, que garantiza la transparencia y una IA ética.

Número contra la eficiencia en China. Cualquiera que haya establecido las baterías en la IA, más allá de las compañías estadounidenses es China. Según una hoja de ruta que difiere mucho de la persona occidental, China se enfoca en (supuestamente) menos GPU que funciona con mayor eficiencia, mucho más baja que la de las empresas estadounidenses y con resultados equivalentes. Deepseek o el Kimi más joven son dos ensayos.

Nvidia se frota las manos. Y hay un claro ganador de toda esta lucha por AI: Nvidia. Por mucho que sea y más allá, quién tiene más o menos GPU para hacer el trabajo, es el claro ganador Nvidia. No está tan claro en China debido al veto comercial, pero los principales centros de cálculo del mundo usan la arquitectura NVIDIA con sus gráficos H100 y H200. Y que cuando hablamos de tarjetas «normales» para IA, ya que tienes el B200 con cuatro veces más alto que el rendimiento del H100.

De hecho, la compañía parece concentrarse en esta carrera de IA que habría llevado a AMD durante años: sus cartas de jugador.

El planeta, no tanto. La consecuencia de esta expansión de IA es que los centros de datos no solo requieren grandes cantidades de energía, sino también agua para guiar el calor del equipo. En el gráfico, Falta Google, que también opera sus centros de datos para la IA y que, junto con otros como Destination o Microsoft Nuclear, necesita control para alimentar sus instalaciones.

El consumo es tan exagerado que las energías renovables no son suficientes durante la demanda de demanda y el uso de combustibles fósiles, como carbón o gas (gas ((gas ( Apreciación El Coloso -GPU consume 300 MW, suficiente para alimentar 300,000 casas), y como dijimos, el uso de agua en las áreas candidatas se ha convertido en material de discusión para acomodar nuevos centros de datos. China necesita tanta disipación para construirla en el fondo del océano.

En | China quiere convertirse en un motor AI World. Y tu plan es hacer dependiente de ti mismo